アナリティクス・ビューで作ったモデルを使って、新しいデータフレームで予測する方法

アナリティクスビューで作成したモデルを使って、新規データフレームに対して予測を行い、予測精度を評価する方法を紹介します。

Exploratoryのアナリティクスでは、モデルに応じて以下の4種類のタイプの値を予測できます。

- 数値

- 論理値(TRUE/FALSE)

- カテゴリー

- 生存確率(生存確率の予測の詳細はこちらから確認いただけます)

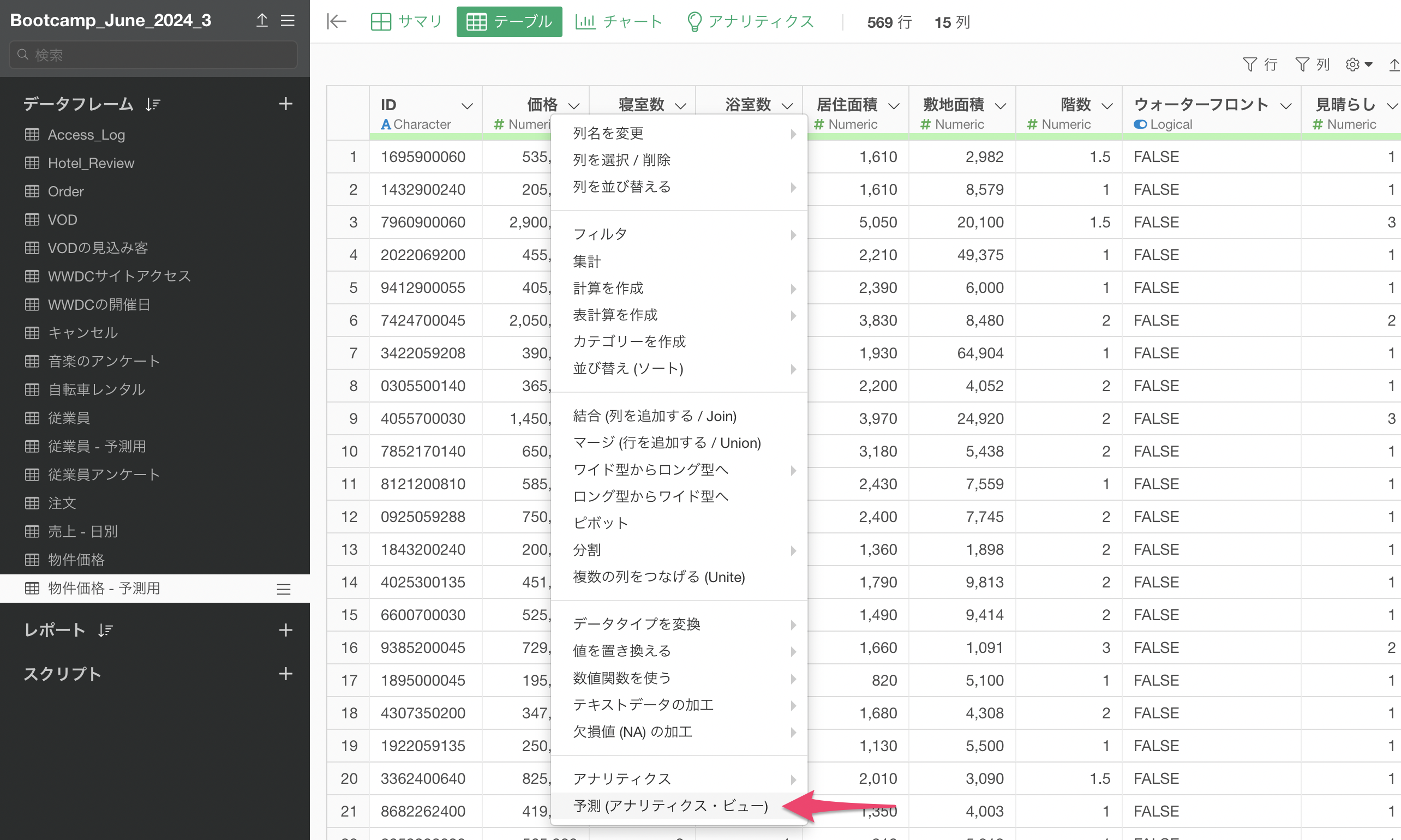

また予測する値のタイプに限らず、アナリティクスビューで作成したモデルを使って新しいデータに対して予測をしたい対象の、新しいデータフレームに移動して、ステップメニューから「モデルで予測(アナリティクスビュー)」を選択します。

すると、予測のためのダイアログが表示されます。

数値・カテゴリーを予測する

モデルで予測のダイアログが開いたら、利用したい予測モデルを作成したデータフレームと、アナリティクス名(アナリティクス・ビューで作成したモデルのタブ名)を選択して、実行します。

すると、予測する対象に応じて、予測結果が返ります。

数値型の場合

数値を予測した場合は、数値型の予測値や関連する指標がデータフレームに追加されます。

カテゴリー型の場合

カテゴリーを予測した場合は、予測されたカテゴリー、そのカテゴリーである予想確率、全てのカテゴリーの予測確率がデータフレームに追加されます。

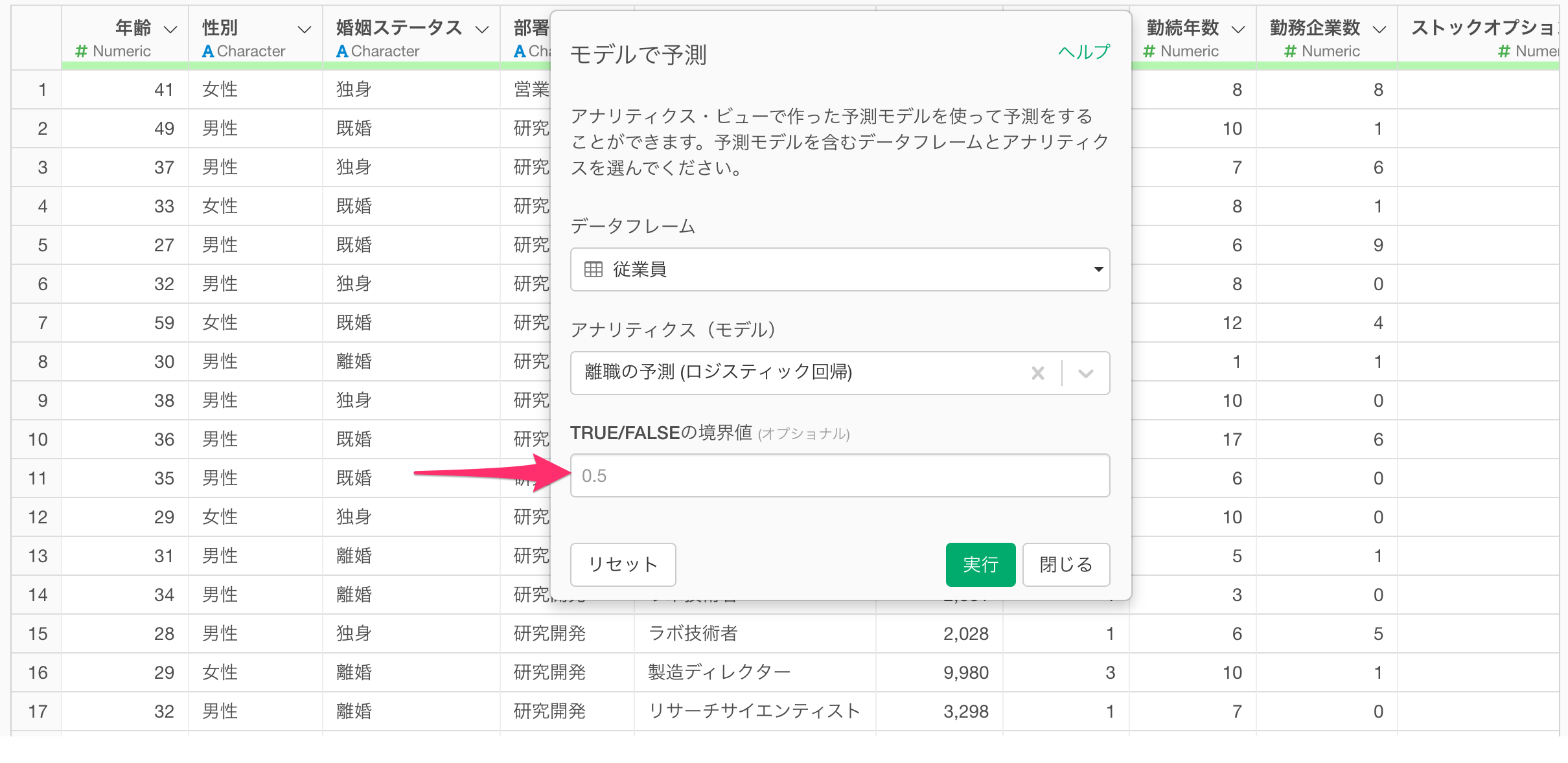

論理値(TRUE/FALSE)を予測する

モデルで予測のダイアログが開いたら、利用したい予測モデルを作成したデータフレームと、アナリティクス名(アナリティクス・ビューで作成したモデルのタブ名)選択します。

論理値(TRUE/FALSE)を予測するモデルを選択している場合、「TRUE/FALSEの境界値」というオプションが表示されます。

これは論理値(TRUE/FALSE)を予測するモデルの場合、論理値そのものを予測しているわけではなく、TRUEになる確率を予測しているためです。

これは論理値(TRUE/FALSE)を予測するモデルの場合、論理値そのものを予測しているわけではなく、TRUEになる確率を予測しているためです。

そのため、論理値(TRUE/FALSE)を予測するモデルの場合、TRUEと返す際の境界値(しきい値)を自ら設定できます。

デフォルトは0.5(50%)になっていますが、0から1の間で境界値は自由に設定できます。

新しいデータに対する予測精度を評価したい

新しいデータに対して実施した予測結果に対する答え(結果・実測値)の列がある場合、予測精度を評価することも可能です。

数値の場合

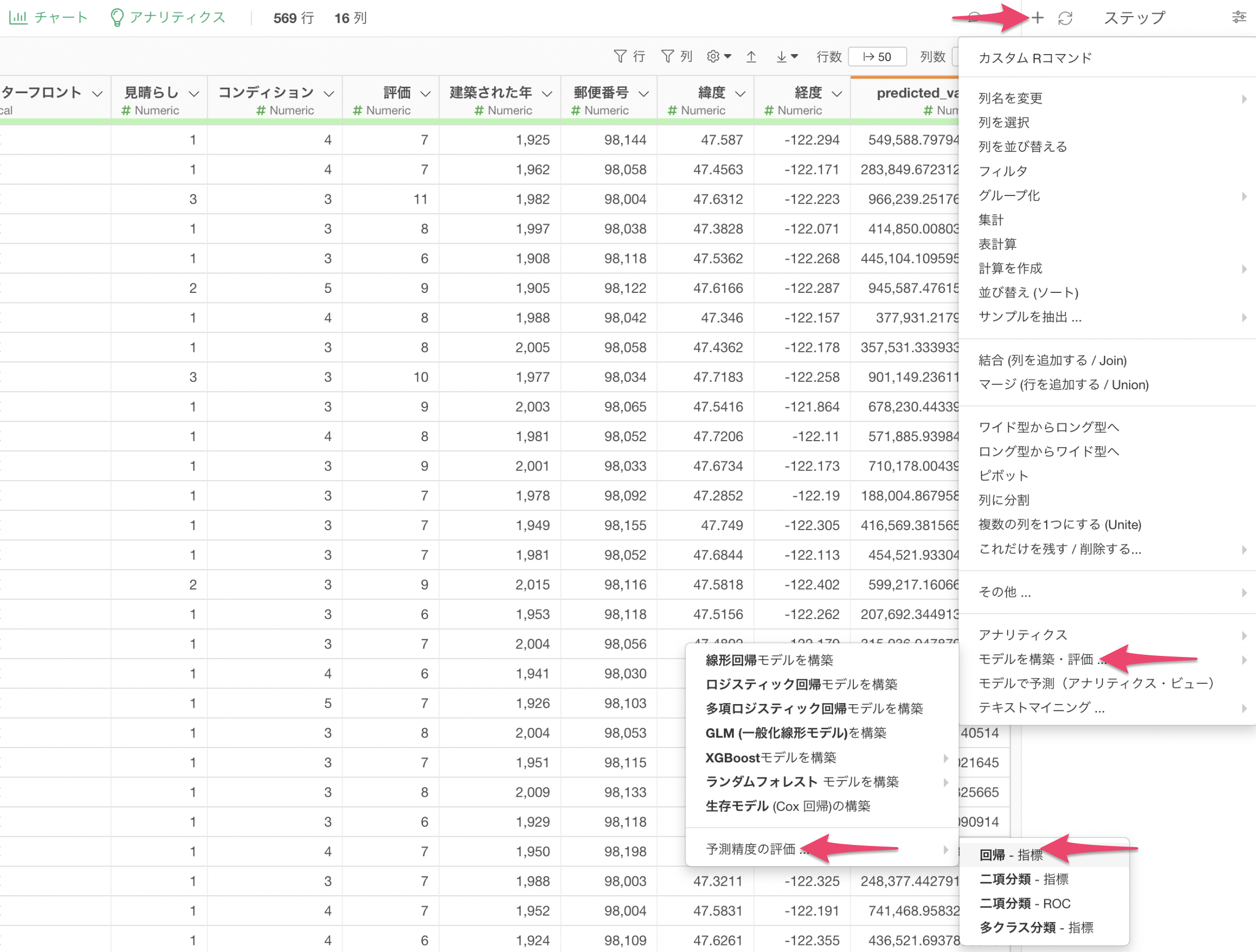

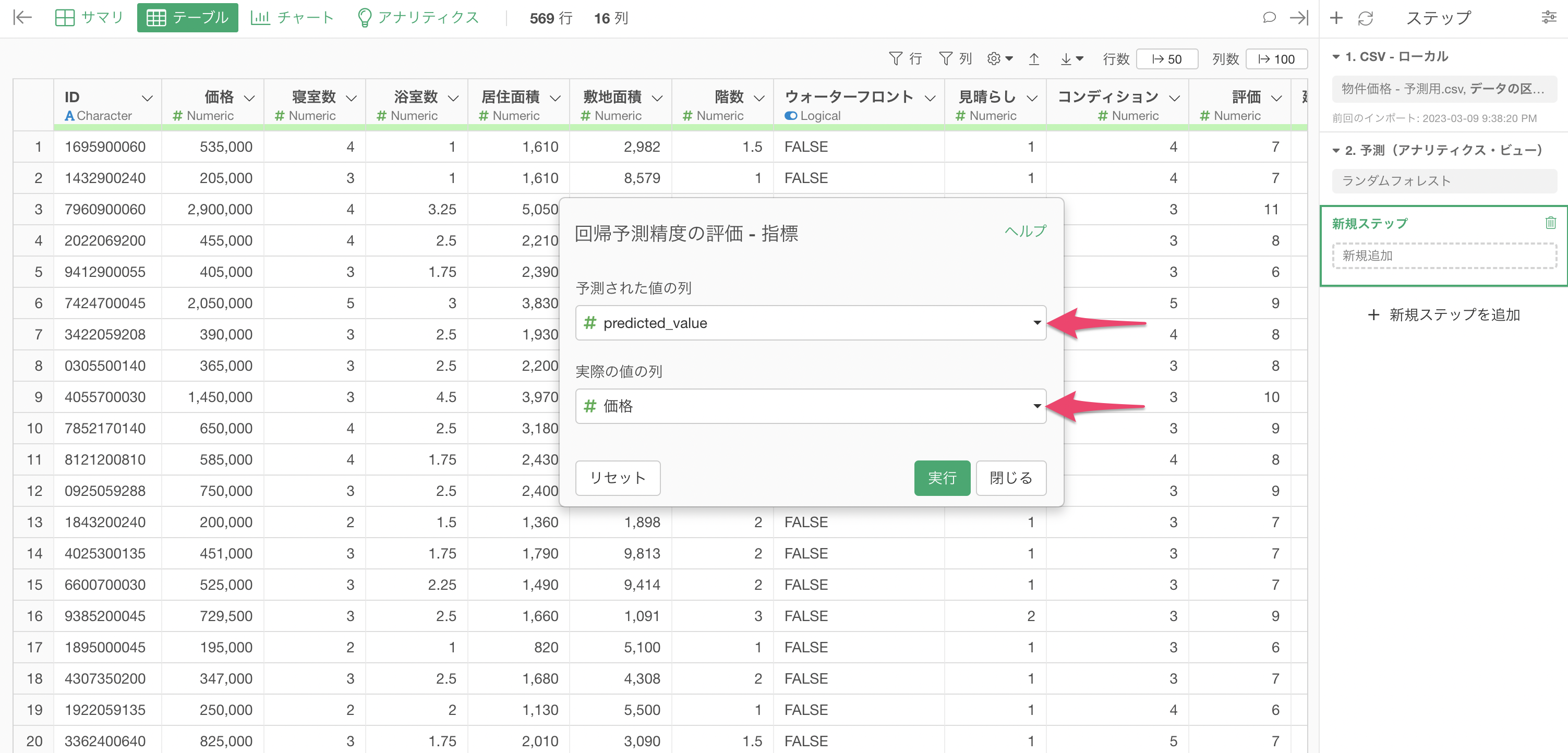

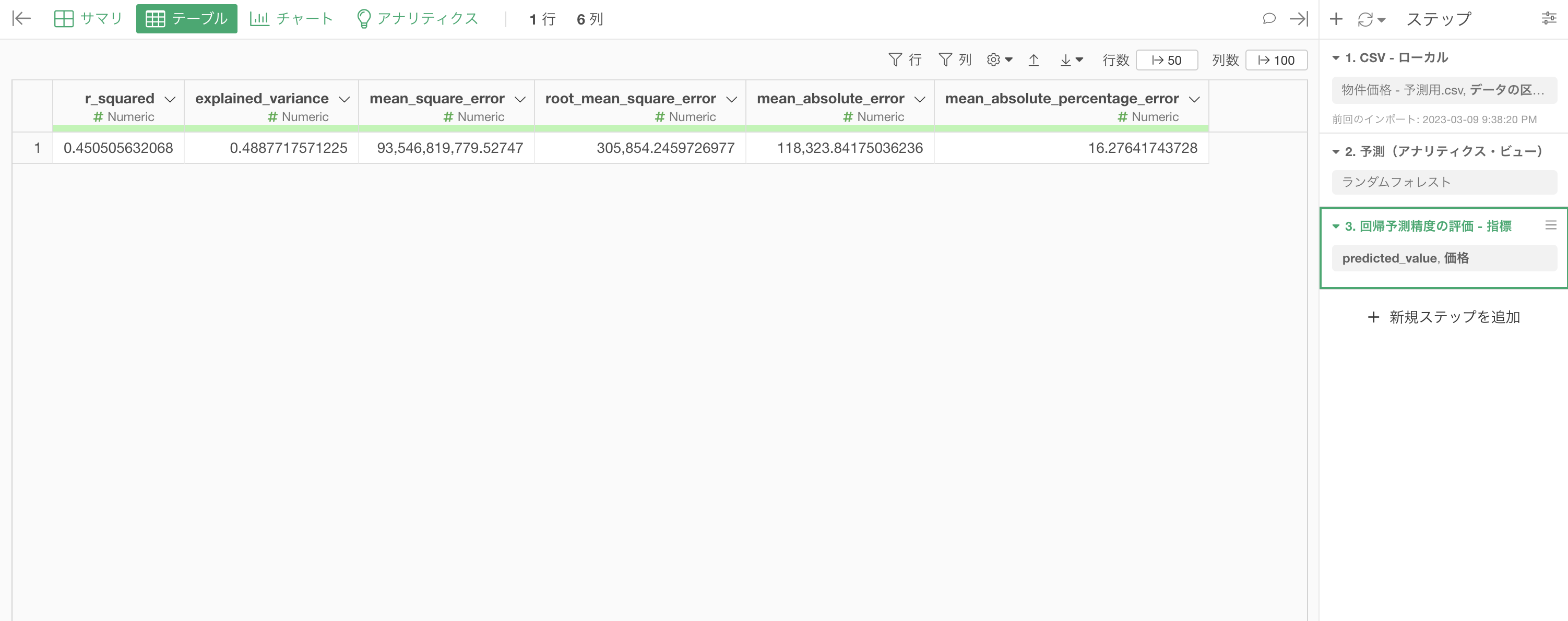

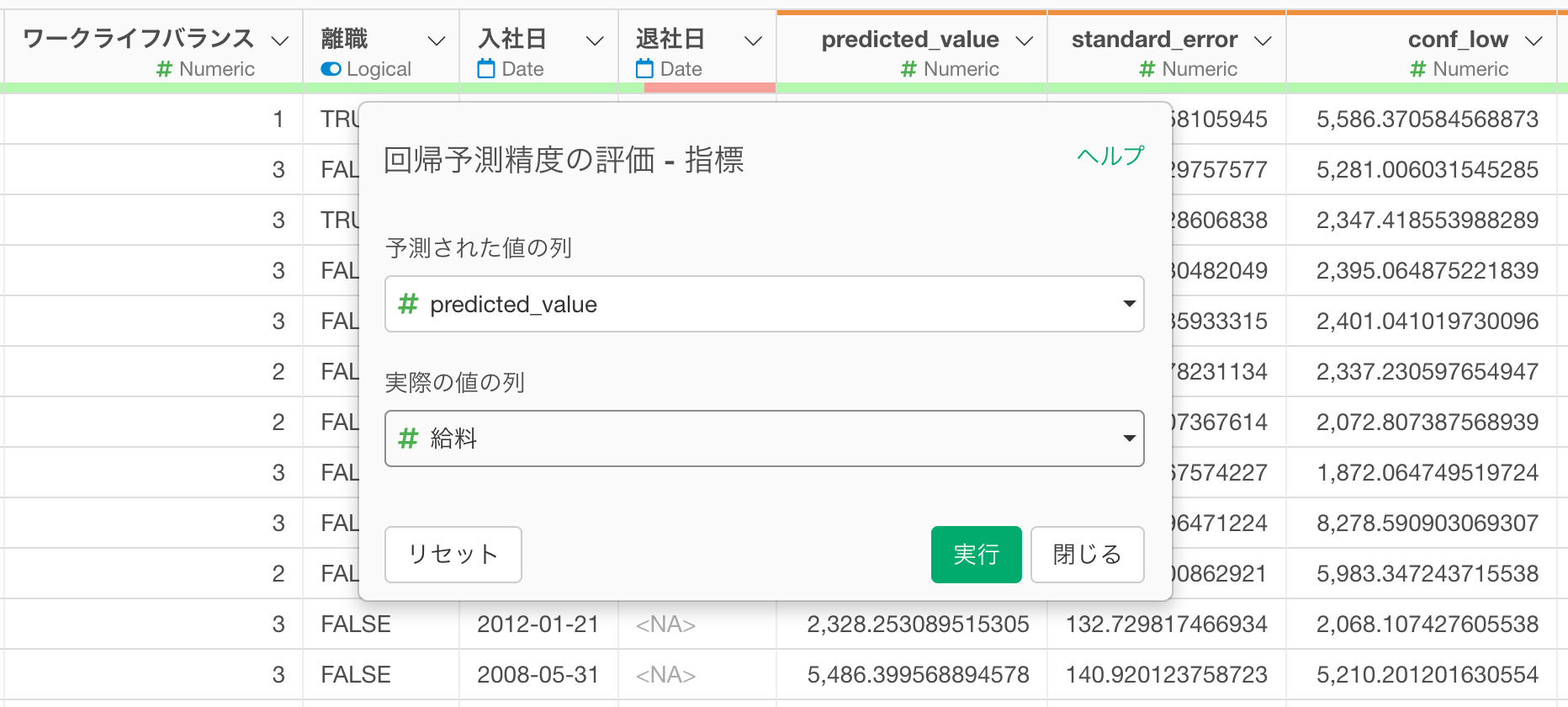

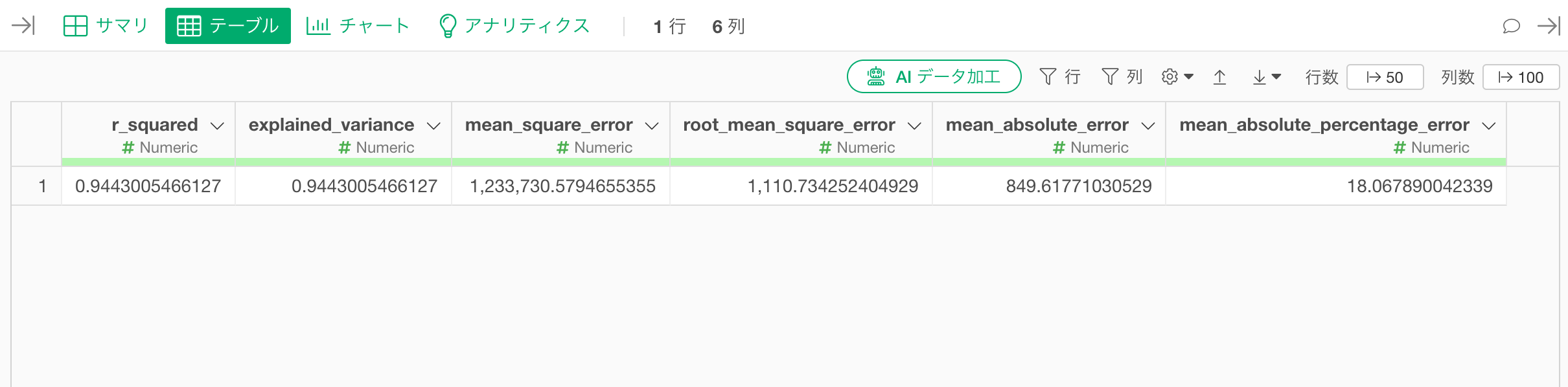

数値型の予測値に対する予測精度を評価したい場合、ステップメニューから「モデルを構築・評価」、「予測精度の評価」、「回帰-指標」を選択します。

予測精度を評価するためのダイアログが開いたら、「予測された確率の列」には該当する列である「predicted_probability」と、実際の数値の列を選択して、実行します。

すると、数値の予測精度を評価する指標の計算結果が表示されます。

論理値の場合

論理値の予測に対する予測精度を評価したい場合、ステップメニューから「モデルを構築・評価」、「予測精度の評価」を選択のうえ、「二項分類

- 指標」または「二項分類 - ROC」を選択します。

二項分類 - 指標

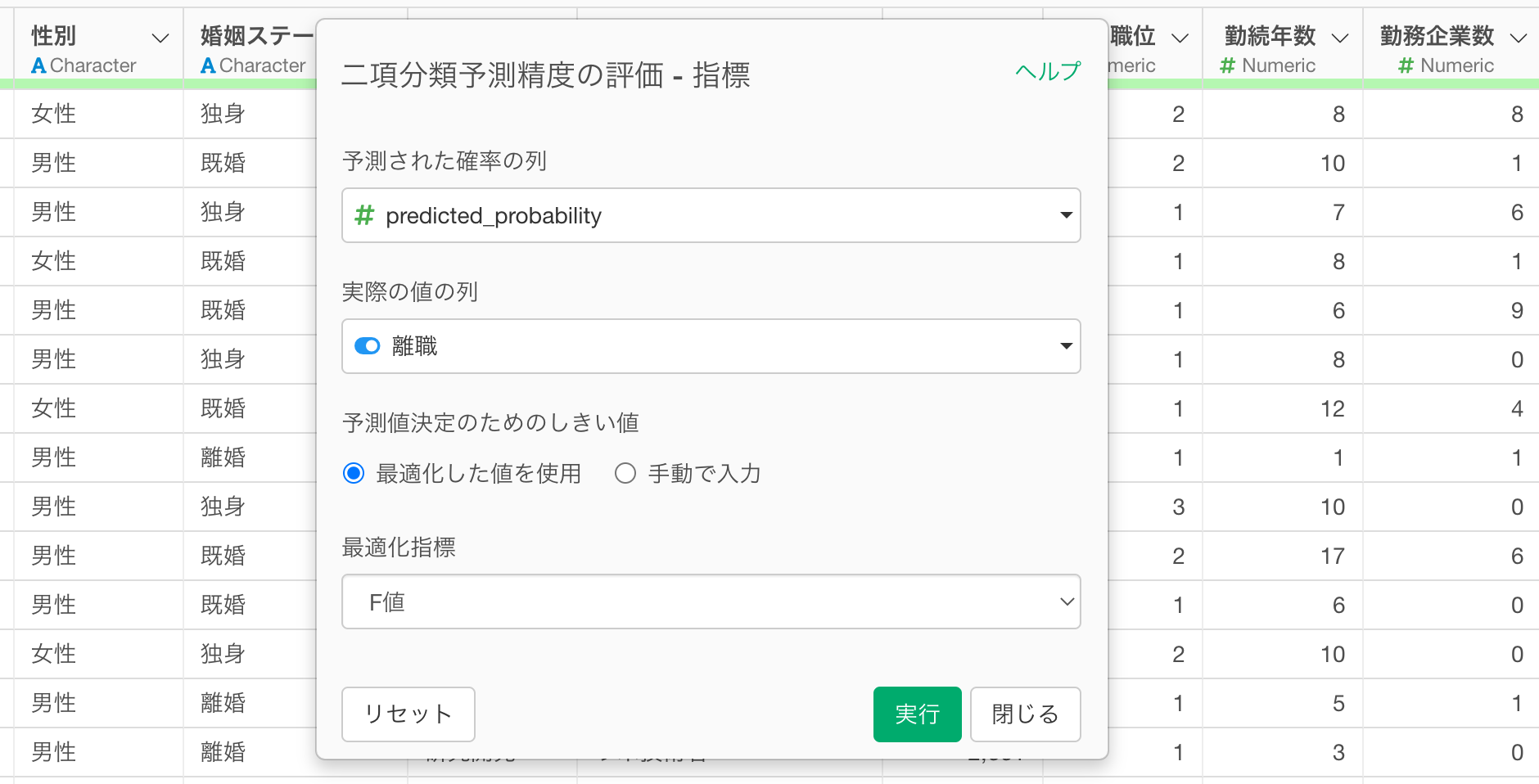

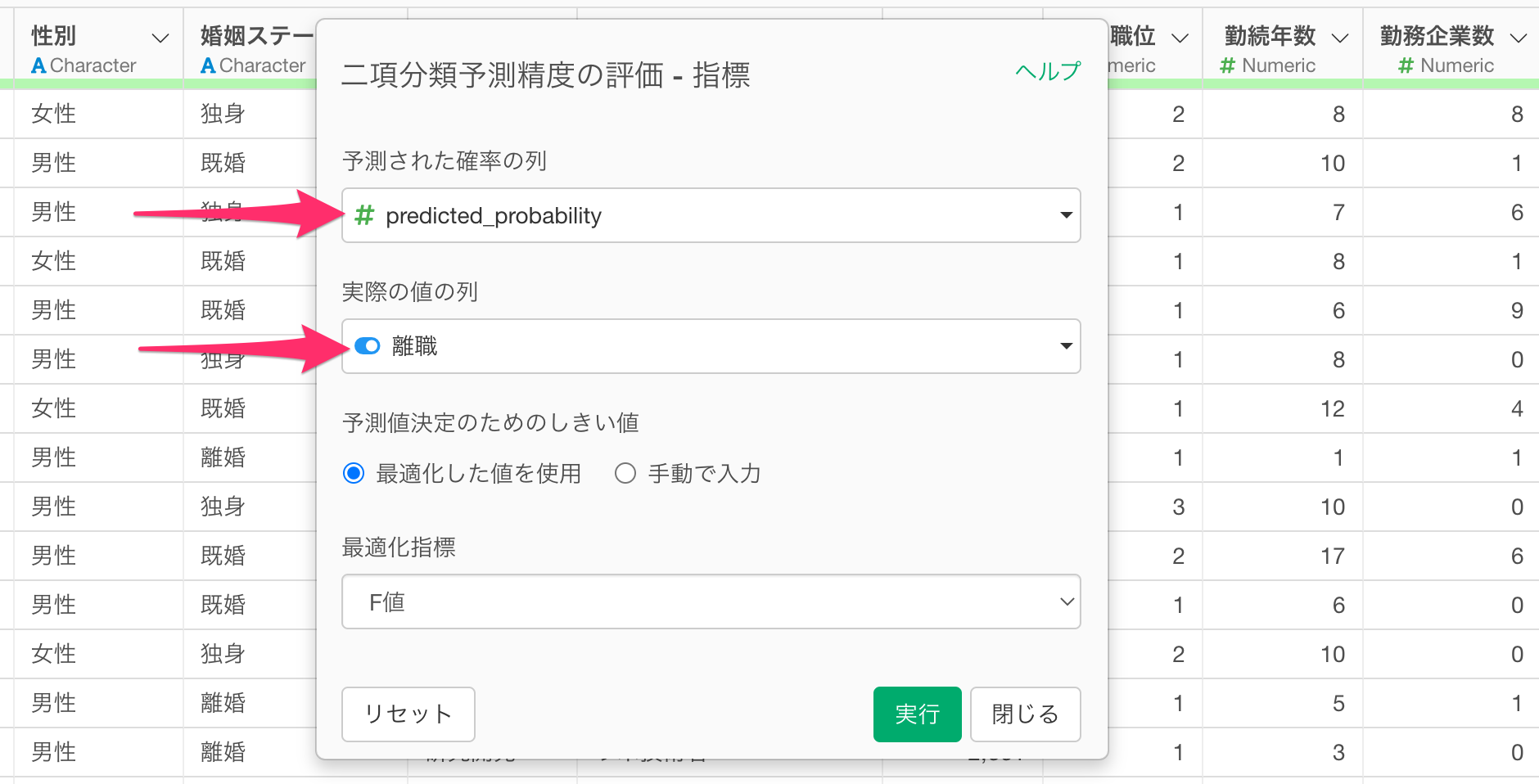

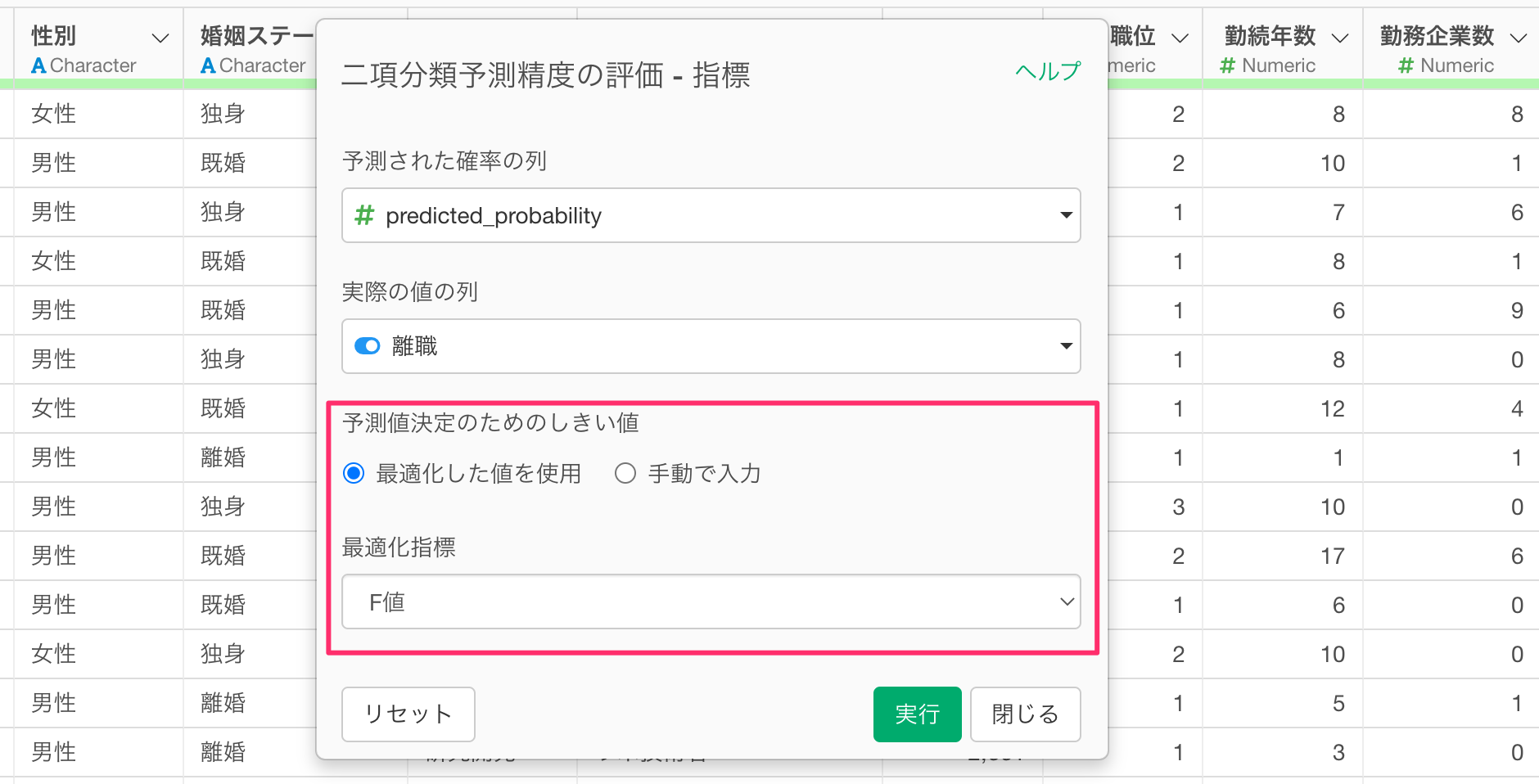

「二項分類 - 指標」を選択した場合、以下のようなダイアログが表示されます。

「予測された確率の列」には該当する列であるpredicted_probabilityを選択し、実際の値の列には、実際の論理値を選択します。

なお二項分類のモデルにおいては、モデルの評価指標が、TRUE/FALSEを決める境界値(しきい値)によって変動するため、手動で入力するか、最適化する指標を選択できるようになっています。

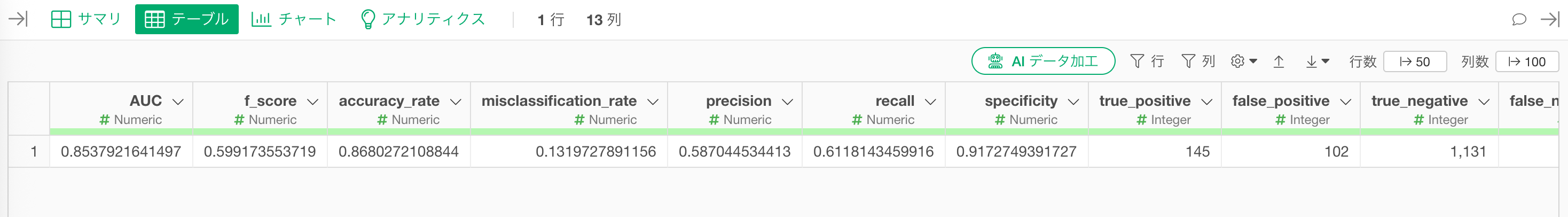

それぞれの設定を終えて実行すると、論理値の予測精度を評価する指標の計算結果が表示されます。

二項分類 - ROC

「二項分類 - ROC」を選択した場合、以下のようなダイアログが表示されます。

「予測された確率の列」には該当する列である「predicted_probability」を選択し、実際の値の列には、実際の論理値を選択します。

すると、論理値を予測するモデルの精度を評価するROC曲線の計算結果が表示されます。

カテゴリーの場合

カテゴリーの予測に対する予測精度を評価したい場合、ステップメニューから「モデルを構築・評価」、「予測精度の評価」、「多クラス分類 - 指標」を選択します。

予測精度を評価するためのダイアログが開いたら、「予測されたラベルの列」には該当する列である「predicted_label」を選択し、実際の値の列には、実際のカテゴリー列を選択し、実行します。

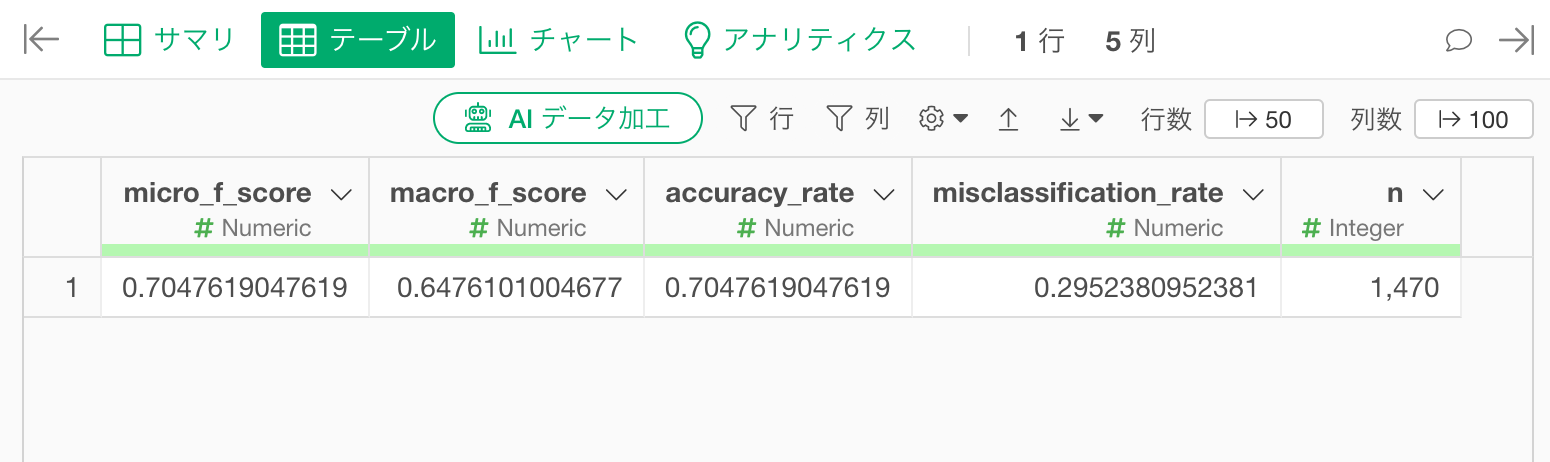

すると、カテゴリーの予測精度を評価する指標の計算結果が表示されます。