Photo by The Climate Reality Project on Unsplash

人間の命を救うはずだったAIが政治と無知によって無視されてしまった話

優れた料理人はお客さんが育てると言うことばがあります。料理を食べるお客さんが、それがほんとにうまいかどうかわからないと、料理人のレベルも上がらないということです。

実はAIにもそれと同じような面があります。

AIがわからない人にAIを渡しても、AIの真価は発揮できないということです。

今回は、汚染された水道管を発見することができるAI(機械学習による予測モデル)をせっかく開発したにもかかわらず、結局使われなくなってしまい、そのせいで問題の水道管が今でも取り替えられず、多くの人の命が危険にさらされていると言う、アメリカのミシガン州のフリントという町で起こった話を紹介したいと思います。

以下、要約。

How a Feel-Good AI Story Went Wrong in Flint - Link

アメリカのミシガン州にフリントという、かつてはアメリカの自動車産業の繁栄とともに栄えたのですが、最近では自動車産業の斜陽とともに寂れてしまっている町があるのですが、そこではこの数年の間、水道水の汚染問題が大変なことになっています。

その対策としてリード(鉛)製の水道管を銅製の水道管にすばやく移行するという計画が立てられました。しかし、この問題になっている水道管とは家の中に見える部分ではなく、地下を掘らなければわからない場所にあるため、一軒一軒の地下を掘って調べなくてはならないのですが、それは気の遠くなるような作業でした。

そこで、機械学習の登場です。

ミシガン大学が、Googleのサポートをもとに機械学習のアルゴリズムを使ってすでに問題があるかないかがわかっている家の情報をもとに、それらに似た属性を持った家を判別する予測モデルを作りました。

これによって問題があると予測された8,833件の家の地下を掘り調査し、そのうちの6,228件で実際に水道管に問題があることが確認され、それらの水道管を取り替えることになりました。

70%ほどの確率で問題の水道管を正しく発見することができたのです。

さらにもっと実際に掘って識別結果のデータが集まれば集まるほどその予測精度は良くなるはずですから、機械学習が地域の住民の命を救う話として数年前に脚光を浴びていたのは記憶にあたらしいところです。

しかし、その後この話は実は急展開を迎えていました。

実は、この機械学習の予測モデルはその後使われなくなってしまっていて、結果的には問題のある水道管の修理作業というのは全く進んでなかったのです。

なぜ使われなくなってしまったのか、以下の3つの点にまとまられます。

1. 使う側にAIがわからない

1.機械学習を使って問題のある場所を予測し、調査すべき工事会社が、かんじんの予測モデルを使うのをやめてしまった。彼らにはそうしたモデルを使いこなすだけの知識とスキルがなかったので、使い続けることに対するモチベーションがなかった。

2.政治的動機

フリントの市長が、機械学習の予測モデルによる予測結果よりも、政治的動機を優先してしまった。

問題のある水道管というのは一部の古い地域に偏って多くあるので、予測モデルはそうした地域を重点的に調べるよう促すわけですが、フリントの全ての住民が自分たちが毎日使う水の品質に対して不安に陥っているときに、全ての地域に公平に水道管を検査するサービスを提供しないわけには行きません。

そこで、市長は全ての地域で公平に検査作業を行っていくという決定を下すわけですが、彼は選挙で選ばれているわけですから、次の選挙を考えるならば、それはある意味当然といえば当然なわけです。

市長は建設会社のAECOMにフリントの街全域をカバーするように要請しました。

市民は「なぜ自分の住んでいる場所が調査のために採掘が行われないのか」と、不満を表明します。そのときにうまく説明することが大変なので、すべての地域を公平に調査するということになってしまったのです。

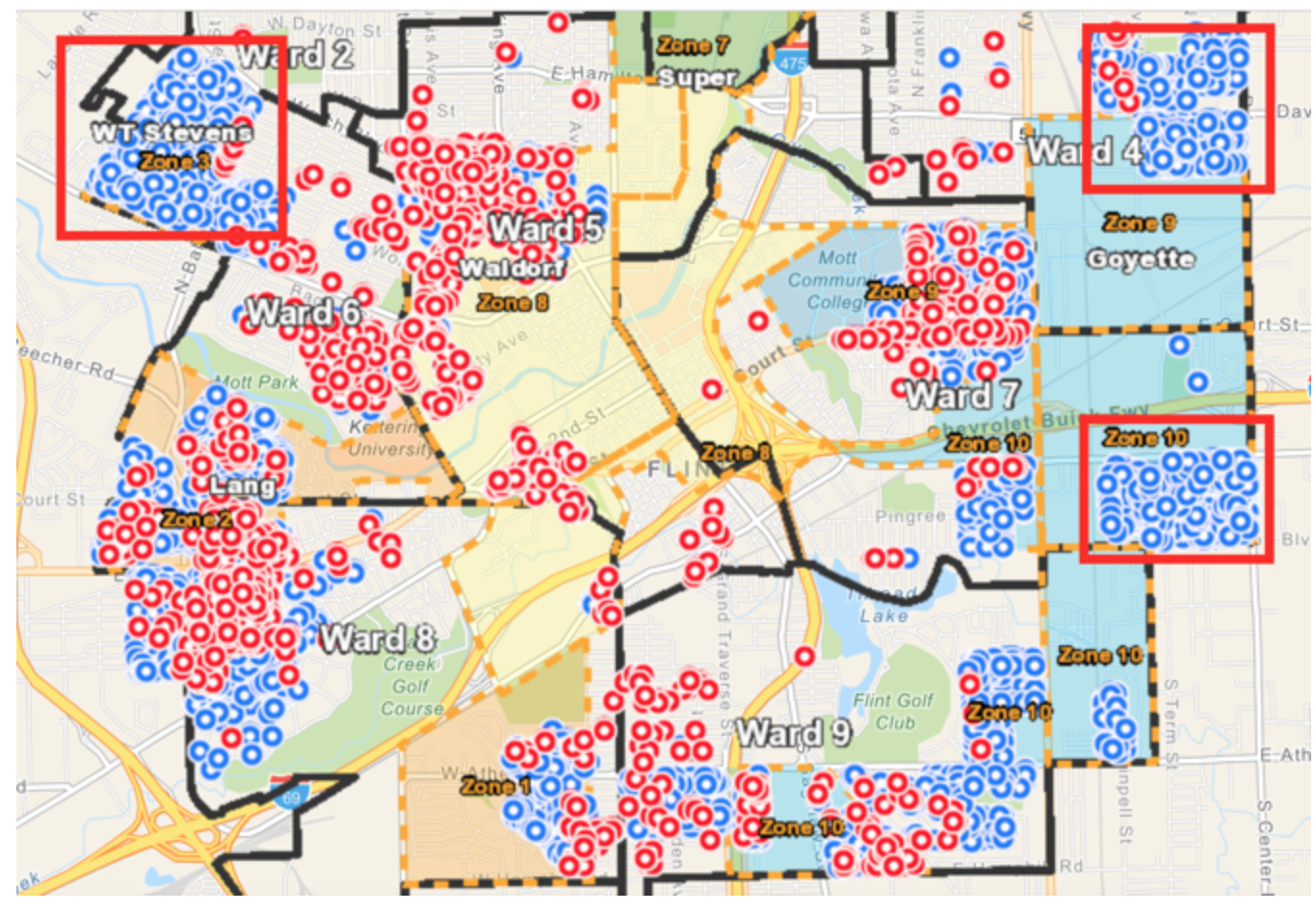

そこで、市を10のゾーンに分け、それぞれのゾーンからランダムに600の住所を取り出し、それらの地下を掘って調査するよう要請したのです。3. 住民にAIによる予測を説明できない

住民に予測モデルの結果を解釈するだけの知識がない。これは何もこのフリントの住民の教育レベルが低いと言ってるわけではありません。

それはたとえ、サンフランシスコや東京の街でも同じようなものだと思います。

例えば、隣の家で水道管の採掘調査作業が行われているときに、もし予測モデルが70%の確率であなたの家は大丈夫ですと言ったとします。あなたは自分の家の地下にある水道管を検査しなくてもいいとほんとうに思えるでしょうか。

特に自分に子供がいたりした場合は、多くの人はここで冷静な判断を下せないと思います。

予測モデルの言うことを無視してでも、全ての家の地下を掘って調べるという意思決定を行いました。なぜなら、「人々は隣の家の地下は調べたのに私の家を調べないのはなぜか?」と不満をいうからです。

こんなときに、「われわれの予測モデルを信用してください。」といっても、一般の市民はそう簡単に信用することはないでしょう。

市としては、そうした声を無視することはできません。そこで重要になるのが、AIの解釈とそのコミュニケーションだと思います。AIによる予測の結果を普通の人間が理解できるレベルで解釈し、そのことを市民に丁寧に説明していく必要があります。こういう教育はいざとなってから始めるのでなく、普段からどんどんと行っていかなければいけません。

以上のようなことで、結局フリントの市と工事会社はAIの予測モデルを使うのをやめてしまい、そのことで、水道管の調査にかかるコストが爆発的に上昇し、かんじんの問題のあるリード製の水道管を取り替えるという作業そのものが大幅に遅れてしまうこととなりました。

下の図では、青の丸が問題のない銅製の水道管が使われている家、赤の丸が問題のあるリード製の水道管が使われている家です。赤で囲まれた3つのゾーンでは何百という家の地下が掘り返されましたが問題のある水道管が見つかることはほとんどありませんでした。特にゾーン10(右下)ではその数はゼロでした。

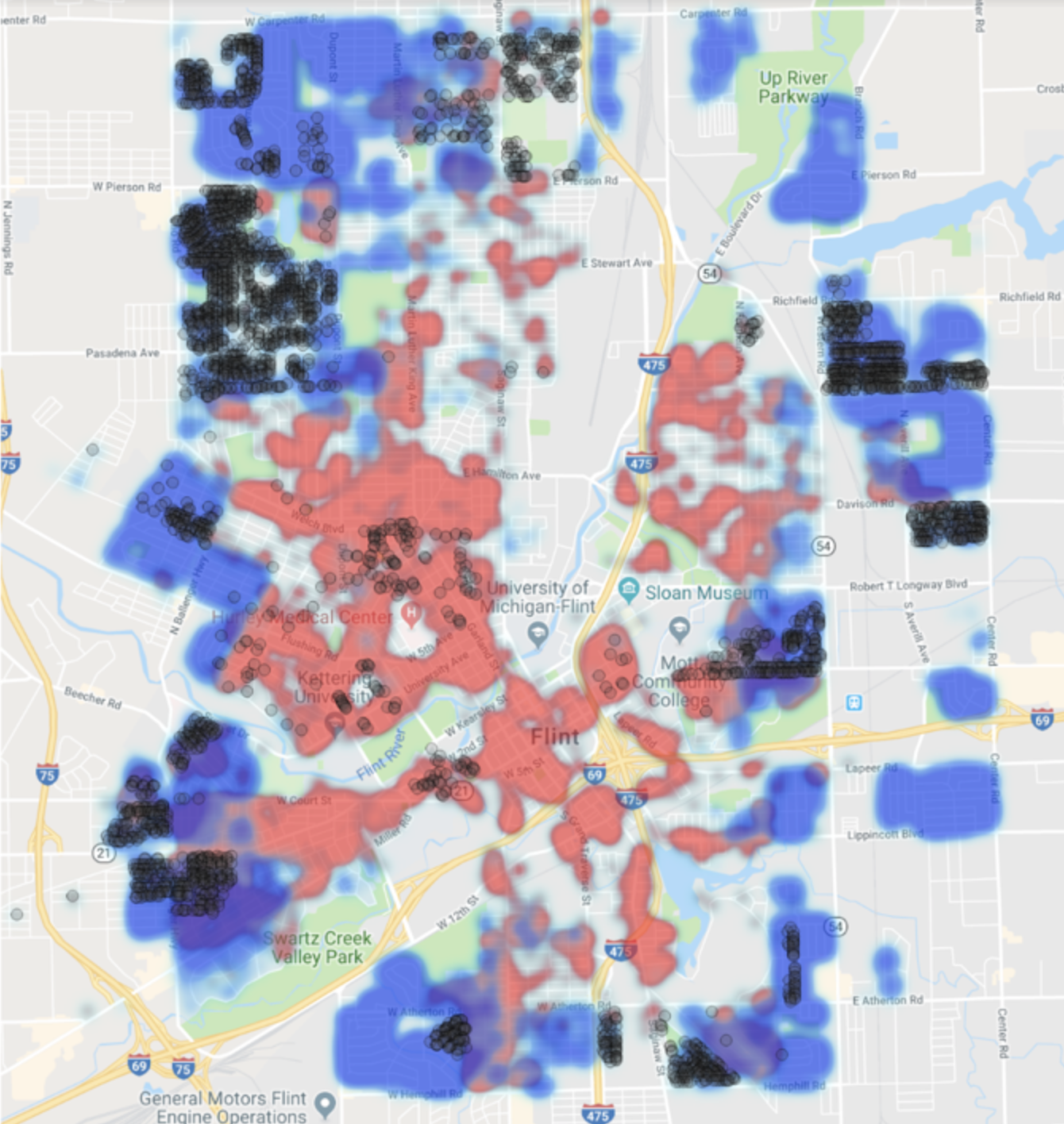

下の図は、機械学習の予測モデルの結果を地図の上で可視化したものです。赤が90%の確率で危険な水道管が使われている家です。青はそうした問題のある水道管が使われていることはおそらくないであろう家です。しかし、工事会社が実際に2018年に地下を掘り返して調査した家は黒い点です。

これを見ると、もしこの予測モデルがそれなりの正解率をだしていると仮定すると、この工事会社による水道管の調査のための採掘作業はまったく的を得ていないことになります。

最終的にこの問題は、市、州、環境活動家、建設会社などの間での訴訟に発展していくことになるのですが、結局もう一度、AIの予測モデルに従って採掘する場所を決め、問題のある水道管を探し出し、取り替えていくという方向で、現在交渉中です。

要約、終わり。

あとがき

この記事を読んで私が興味深いと思ったのは、こうした問題は何もミシガン州のフリントだけに起こり得る問題ではなく、むしろこれから、こういう問題は日本でもいろんなところで起きてくるだろうなと思ったからです。

この記事にあるように、どんなにAIの予測結果が優れていたとしても結局はそうしたものを使うのは人間である限りは、結局は人間のほうがしっかりと進化していなくてはせっかくのAIの世界で起きている進化も宝の持ち腐れになってしまうということです。

英語で「You get what you deserve」という表現があります。これはSteve Jobsが健在であった当時の話ですが、例えば、同じ広告会社を使っていても、AppleとDellの広告は全く違っていました。

結局、AIを使う人に「AIのセンス」がどれだけあるかで、AIが真価を発揮できるかどうかは決まってくるのだと思います。

これは何もAIのアルゴリズムだとか裏にある理論を理解していなければいけないといった意味ではなく、それよりもっと使う側の視点で、現在のAIに期待できること、限界と前提、またアウトプットの解釈の仕方を理解しておく必要があるのだと思います。

ビジネスの場合、AIをプロダクトやシステムに組み込む、またはデータ分析にAIのアルゴリズムを使うといった場合に、もちろんそれを使う人にAIの理解が必要なのは当たり前ですが、それ以上にそのAIから出されるアウトプットによって影響を受ける人たちにAIをしっかりと説明する必要がでてきます。

この部分の教育を急がなくては、どんなにAIの精度がよくなり、AIを使うプロダクトの機能やビジネスがどんどんと出てきたとしても、結局は宝の持ち腐れとなってしまいかねません。

データサイエンス・ブートキャンプ、3月開催!

今年の3月の中旬に、Exploratory社がシリコンバレーで行っているトレーニングプログラムを日本向けにした、データサイエンス・ブートキャンプを東京で開催します。

データサイエンスの手法を基礎から体系的に、プログラミングなしで学んでみたい方、そういった手法を日々のビジネスに活かしてみたい方はぜひこの機会に参加を検討してみてください。詳しい情報はこちらのホームページにあります!